Robots.txt per Magento

Magento non ha un Robots.txt!

Strano ma vero, la distribuzione ufficiale di Magento non include un file robots.txt predefinito.

Non c’è da allarmarsi per questo, ma vale la pena riflettere qualche minuto per rendersi conto degli effetti di questa mancanza su un sito ecommerce Magento in produzione e

dunque valutare i benefici che si possono trarre dalla creazione di un file robots.txt ad-hoc per il proprio store Magento.

Un file robots.txt per Magento

Il file robots.txt consente di regolare l’accesso e l’indicizzazione di determinate aree di un sito da parte non solo dei motori di ricerca ma anche di numerosi spider, crawler e servizi di vario tipo.

Ricordiamo comunque che il rispetto delle direttive contenute nel file robots.txt è del tutto volontario è nulla garantisce che qualsiasi forma di crawler rispetti che questa convenzione.

Come già detto, curiosamente Magento viene distribuito senza un file robots.txt predefinito.

Ciò di per sé non è un grosso problema, tuttavia ne raccomandiamo caldamente la creazione poiché un buon file robots.txt può migliorare i seguenti aspetti:

Sicurezza e confidenzialità

Limitare l’accesso ad aree amministrative e di sistema, e comunque che non siano utili per il visitatore del sito. Questo può evitare che cartelle e file aggiunti in un secondo momento vengano indicizzati involontariamente. Pensiamo ad un file con il dettaglio ordini o spedizioni, magari contenente riferimenti ai clienti o prodotti acquistati che potrebbe essere involontariamente indicizzato…

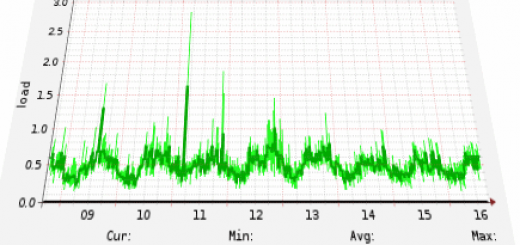

Prestazioni

Limitare l’accesso da parte di robots vari a determinate aree del sito può aiutare a diminuire il carico sul server ed il consumo di banda, dunque è anche una forma di ottimizzazione delle risorse e prestazioni del server che ospita Magento.

L’impatto che questa piccola ottimizzazione può avere su un server VPS comune può essere anche molto significativo: bastano una manciata di motori di ricerca che nello stesso momento vanno a scansionare centinaia di url per rallentare notevolmente il sito.

Indicizzazione e SEO

Lasciare che ciascun robot indicizzi indiscriminatamente qualsiasi url del nostro sito può avere effetti negativi anche per quanto concerne l’aspetto SEO.

Utilizzare il file robot.txt per evitare l’indicizzazione di contenuti e pagine duplicate o di scarso valore per il visitatore è probabilmente una direttiva ampiamente condivisibile.

Creazione di un file robots.txt per Magento

Quello che segue è un file piuttosto aggressivo, a seconda dei casi potremmo voler consentire l’indicizzazione ad esempio di recensioni o dei feed.

User-agent: *

# Directory

Disallow: /app/

Disallow: /cgi-bin/

Disallow: /dev/

Disallow: /downloader/

Disallow: /errors/

Disallow: /includes/

Disallow: /lib/

Disallow: /pkginfo/

Disallow: /shell/

Disallow: /var/

Disallow: /magmi*

Disallow: /old/

# Percorsi

Disallow: /admin/

Disallow: /catalog/

Disallow: /catalogsearch/

Disallow: /checkout/

Disallow: /customer/

Disallow: /feeds/

Disallow: /report/

Disallow: /review/

Disallow: /sales/

Disallow: /sendfriend/

Disallow: /tag/

Disallow: /wishlist/

# File

Disallow: /cron*

Disallow: /LICENSE*

Disallow: /RELEASE_NOTES.txt

Disallow: /install.php

# Varie

Disallow: /index.php/

Disallow: /*?*

Se ci è sfuggito qualcosa o qualcuno avesse suggerimenti od osservazioni circa questo file può segnalarcelo tramite i commenti o via email.

Download del file robots.txt per magento.